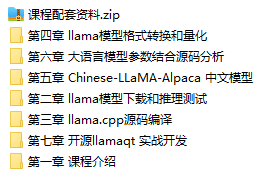

课程大纲

一 llama模型分析和推理测试

llama模型分析和预训练数据来源分析

llama模型下载脚本依赖环境安装

llama的7B、13B、30B、70B模型下载

llama推理测试程序演示

二 llama.cpp构建

llama.cpp源码下载和构建环境分析

构建依赖VisualStudio2022安装

构建依赖CMake安装

llama.cpp在windows构建和项目分析

三 llama模型格式转换和量化

ggml格式介绍

conda在windows中的安装和使用

llama的pth格式转换为ggml的bin

使用llama.cpp量化llama模型适应低性能设备

四 Chinese-LLaMA-Alpaca 中文模型

Chinese-LLaMA-Alpaca模型分析和下载

Transformers安装和llama模型格式转换

合并LoRA权重生成全量模型权重

使用Transformer和Web图形界面实现推理

使用llama.cpp量化和推理中文模型

五 大语言模型参数结合源码分析

推理参数和采样参数说明

llama参数ctx-size上下文大小相关代码分析

predict和batch-size回复数量和推理批次代码分析

增加结果多样性-重复惩罚repeat-penalty

温度改变随机性top-k和top-p算法分析

六 开源llamaqt 实战开发

基于cmake完成项目构建

XGtp模块-推理模块-支持扩展不同的推理算法

XGtp模块-日志子模块

XGtp模块-控制台转发模块

QT交互界面开发对话界面

模型加载、参数设置界面

运行状态和日志显示

课程目录:

1-1.课程介绍.mp4

1-2.推演程序演示,基于130亿参数模型.mp4

2-1.llama模型分析和训练数据分析.mp4

2-2.git和msys2安装和llama模型下载.mp4

2-3.llama推理测试程序演示.mp4

3-1.llama.cpp构建环境说明.mp4

3-2.visutal_studio_2022安装.mp4

3-3.llama.cpp构建和项目分析.mp4

3-4.cmake windows安装二进制版本.mp4

4-1.ggml格式介绍.mp4

4-2.conda在windows中的安装和使用.mp4

4-3.conda的python环境安装.mp4

4-4.llama的pth格式转换为ggml的bin.mp4

4-5.llama量化模型到Q4_0.mp4

5-1.Chinese-LLaMA-Alpaca 中文模型分析和下载.mp45-2.Transformers安装和llama模型格式转换.mp4

5-3.合并中文LoRA权重和llama生成全量模型权重.mp4

5-4.使用Transformer和Web图形界面实现推理.mp4

5-5.使用llama.cpp量化和推理中文模型.mp4

6-1.llama参数ctx-size上下文大小相关代码分析.mp4

6-2.predict和batch-size回复数和推理批次代码.mp4

6-3.增加结果多样性-重复惩罚repeat-penalty.mp4

6-4.21温度改变随机性top-k和top-p算法分析.mp4

7-1.开源llamaqt项目分析说明.mp4

7-2.基于llama.cpp的cmake项目配置和模型加载代码实现.mp4

7-3.完成了推理预处理prompt代码.mp4

7-4.完成了推理结果逻辑表采样并输出.mp4

7-5.完成了精简版的推理示例程序.mp4

7-6.xllama接口类图设计说明.mp4

7-7.XGp测试项目和线程启动停止代码完成.mp4

7-8.XGpt用户输入和线程接收和回调反馈完成.mp4

7-9.完成xllama的推理和反馈接口并测试.mp4

7-10.XGptFac工厂类创建.mp4

7-11.基于cmake配置了推理QT项目.mp4

7-12.完成了基于QT的推理交互程序.mp4

课程配套资料.zip

吾爱学吧.png)

吾爱学吧.png)

.png)

暂无评论内容